Zadzwoń: (+48) 501 099 099

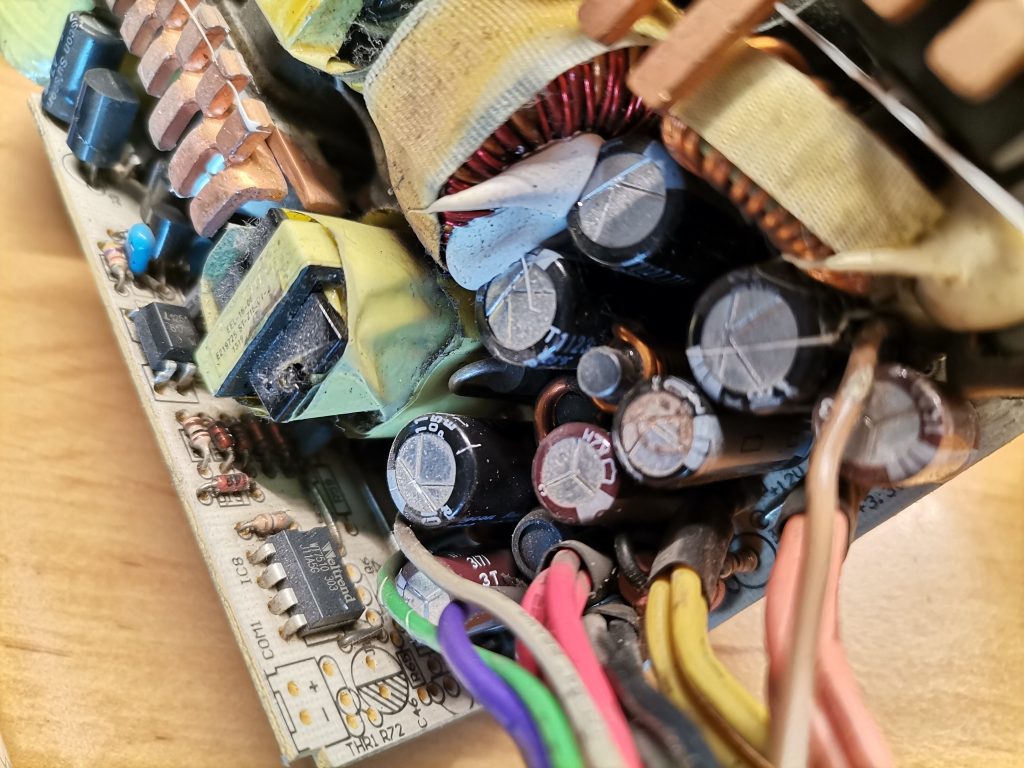

Trafił do mnie Netgear ReadyNAS_NV+. Usterka „nie działa” okazała się być bardzo poważna. Urządzenie po włączeniu wydawało jednorazowo sygnał dźwiękowy i na tym kończyła się interakcja. Pierwsza diagnoza wskazywała na uszkodzony zasilacz, jednak próby uruchomienia na innym zasilaczu nie powiodły się. Dokonałem wnikliwej analizy elektroniki i okazało się, że zasilacz jest uszkodzony, ale uszkodzeniu uległa także płyta główna urządzenia. Naprawa była zupełnie nieopłacalna.

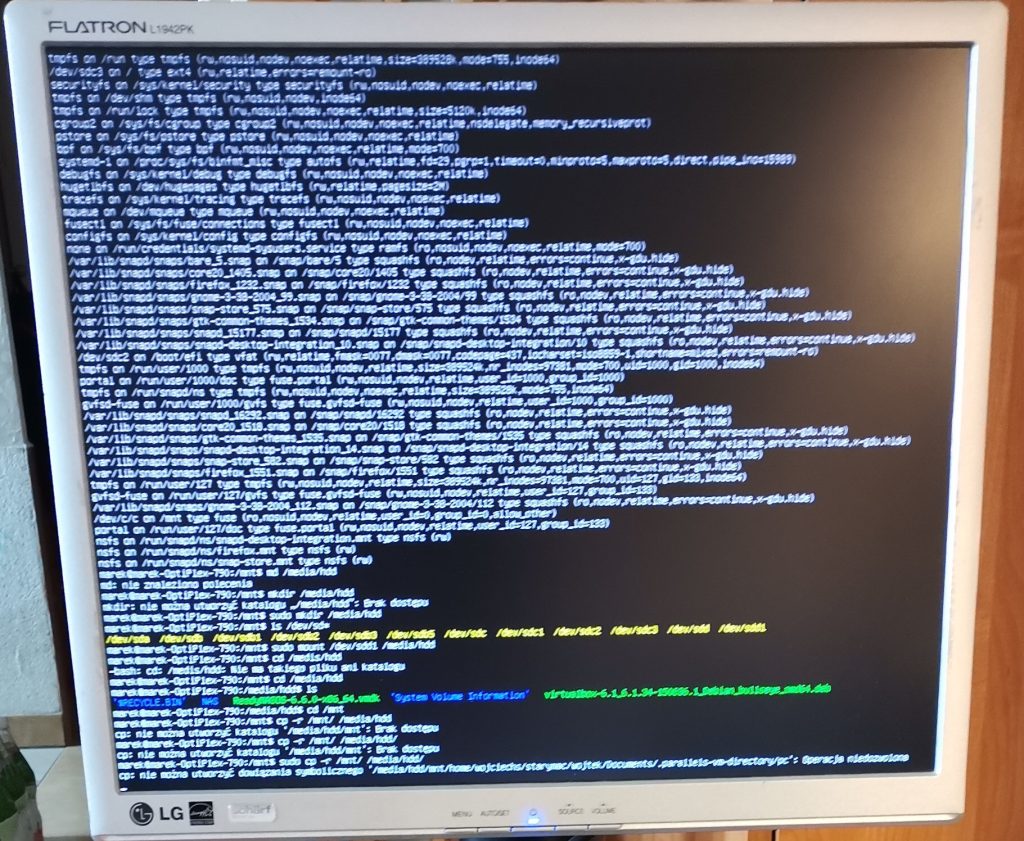

Okazało się również, że jeden z dysków pracujących w zapisie równoległym uległ awarii. W pierwszej kolejności należało zabezpieczyć dane z pozostałego dysku. Podłączyłem dysk do komputera serwisowego, który pracuje pod systemem Linux. Standardowe zmontowanie dysku pokazało jedynie pustą przestrzeń, więc trzeba było szukać innych możliwości. Dopiero podłączenie dysku jako LVM dała pozytywny wynik. To jednak nie koniec trudności ze skopiowaniem danych. Dane co prawda były widoczne, ale skopiować się nie dawały. Było to spowodowane różnicą w sposobie zapisu przez serwer Netgear z procesorem SPARC, a komputerem na bazie procesora Intel. Należało znaleźć sposób na przetłumaczenie zapisu ReadyNAS NV+ na język Intela. Zajęło mi to dłuższą chwilę. W końcu udało się uruchomić kopiowanie plików. Dysk 500 GB ( Seagate ST3500312CS ) był zajęty w około 85%. Wykonałem dwie kopie danych na osobnych dyskach, w formacie linuxowym. Dane były bezpieczne.

Kopia danych do bieżącego użytku

W celu zapewnienia ciągłości pracy wykonałem kolejną kopię danych. Tym razem na dysku przenośnym, na partycji NTFS. Dysk zainstalowałem w siedzibie klienta i udostępniłem w sieci lokalnej, aby pracownicy mogli korzystać z zasobów.

Nowy serwer

Teraz przyszła pora na podjecie decyzji o sposobie udostępniania plików pracownikom. Opcji było kilka:

1. Udostępnianie przez komputer pracujący w sekretariacie ( Windows 10 );

2. Zakupiony serwer plików;

3. Dedykowany serwer pików na bazie komputera.

Pierwsza koncepcja została zarzucona na wstępie ze względów wydajnościowych, gdyż komputer mógłby spowolnić pracę wykonując dodatkowe zadania. Kolejnym argumentem przeciw temu pomysłowi były względy bezpieczeństwa danych.

Dedykowany serwer plików okazał się najlepszym pomysłem. Ostatecznie konkurs wygrał serwer na bazie komputera. Na ostatecznej decyzji zaważyła skalowalność takiego rozwiązania i perspektywiczna możliwość modernizacji urządzenia poprzez instalację dodatkowych kart sieciowych, instalacji nowych usług i bieżącej aktualizacji całego systemu. Innym aspektem przemawiającym za tym rozwiązaniem była możliwość prostego odzyskiwania danych z dysków w razie awarii.

Baza – komputer

Na bazę dla naszego serwera wybrałem nie pierwszej nowości komputer z procesorem Intel Core 2 Duo, z 3 GB RAM, w dużej obudowie. Trzeba było zakupić do niego dyski:

– jeden startowy, na system operacyjny ( SSD 128 GB Goodram SSDPR-CX400-128-G2 )

– dwa dyski robocze na dane, które w założeniu mają pracować w systemie RAID 1 ( tak zwany mirroring ) czyli zapis jednocześnie na dwóch nośnikach. ( HDD 4TB Western Digital WD40EFAX-68JH4N0 ). Dyski z serii WD Red dedykowane są do pracy właśnie w serwerach plików i macierzach dyskowych.

Potrzebna była jeszcze karta sieciowa 1000 mb/s, żeby system działał sprawnie.

Po zainstalowaniu dysków w obudowie komputera i podłączeniu całość uruchomiła się bez problemu. Zainstalowałem system Linux i przystąpiłem do wgrania danych z dysku zapasowego. Operacja przebiegła pomyślnie, chociaż trwała kilka godzin. Kolejne godziny zajęło mi zakładanie użytkowników, konfiguracja usług dostępu do plików poprzez sieć Windows, instalacja i konfiguracja panelu sterowania. Dodatkową atrakcją była synchronizacja danych z chmurą OneDrive oraz instalacja oprogramowania prywatnej chmury umożliwiającej dostęp do plików i innych usług z każdego urządzenia podłączonego do sieci. Po tych wszystkich operacjach i kilku testach można było zawieźć serwer do klienta.

Konfiguracja komputerów w siedzibie klienta

Po podłączeniu serwera do sieci lokalnej i zasilacza awaryjnego UPS przyszła kolej na konfigurację adresu IP. Było to łatwe z pomocą zainstalowanego panelu sterowania. Przyszła kolej na połączenie komputerów z serwerem plików za pomocą Windows, co też nie nastręczało kłopotów. Kolejnym krokiem była instalacja oprogramowania chmury prywatnej na urządzeniach, które mają pracować poza biurem. Na koniec synchronizacja danych z dyskiem, na którym firma działała w „trybie awaryjnym” i gotowe.

Klient zadowolony, twierdzi, że nowy serwer działa o wiele szybciej. Tak miało być.